数据分析是不断探索数据背后的规律进而得出业务洞察的过程,在进行分析前分析师需先将原始数据转换为面向分析、有业务语义的数据。数据准备的产出既可应用于各种数据分析工作,也能作为数据集应用于各种场景化数据产品,具体来说数据准备将原始数据转化为:准确、一致、清晰,并且有一定业务含义的数据,是数据和业务之间的桥梁和纽带,也是一个不断迭代、改进、优化的过程。

最新行业报告显示,数据分析师超过60%的时间都花在数据准备中的:数据清洗和数据整理上,真正用来探索数据,获取业务洞察的时间反而有限,工作效率急需提高。

HENGSHI SENSE 数据准备

HENGSHI SENSE 基于湖仓一体的架构,将 ETL 的经典数仓加工范式改为 ELT 的更加敏捷的数据准备过程,结合 HQL 的语义层能力,将 Transform 的环节虚拟化实现,得到更加敏捷的数据处理管道,其高性能且灵活的 ELT 工作流加之自身业务侧和技术侧的优势,能让客户在数据准备上的工作变的更高效。

在 HENGSHI SENSE 的协同式数据准备中,分为两大版块:数据集成和数据科学,下面将围绕两大板块进行详细解读。

数据集成

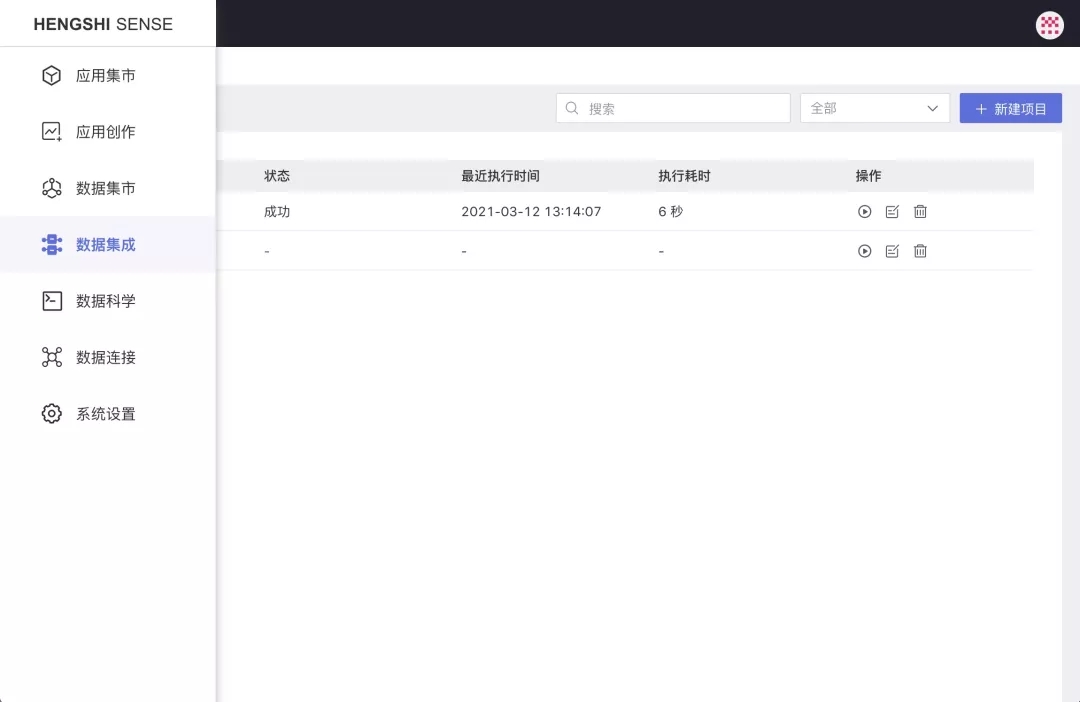

当多源数据连接状态显示成功后,数据集成提供 ELT 这里会对不同来源的数据进行抽取、过滤、转换格式、添加计算列、关联、合并、聚合等处理,再输出到用户指定的数据源中,供后续探索分析用。

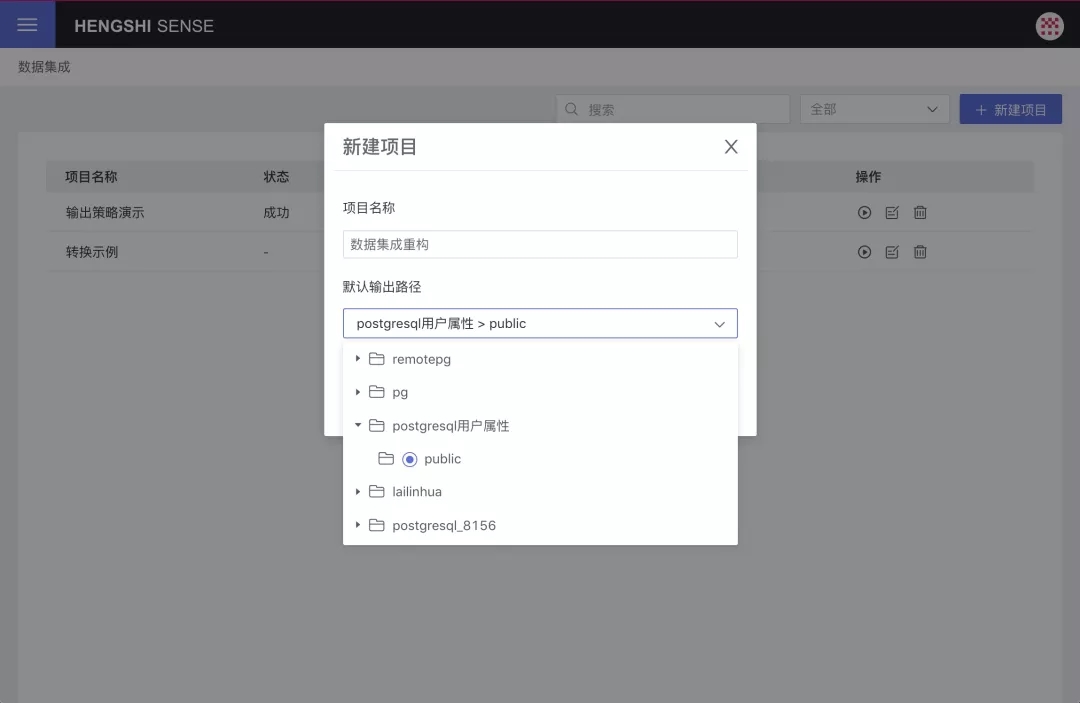

新建数据集成项目后,后台提供 Greenplum、PostgreSQL、Amazon Redshift、Mysql 四种数据源作为输出路径。

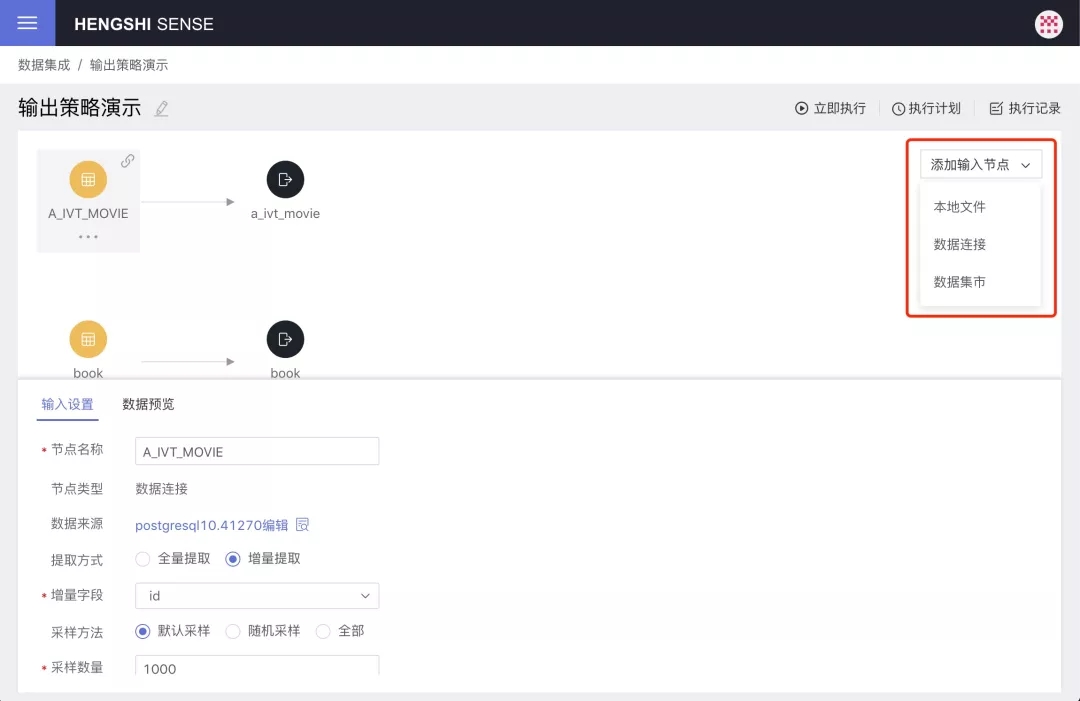

有本地文件、数据连接、数据集市三种类型输出节点。

其中本地文件:支持上传 csv、excel 两种格式

数据连接:分为内置数据连接和用户数据连接两大类

数据集市:可将数据集的成果导出到输出源中,方便客户探索使用

整个项目按照:提取数据->加载前 SQL->验证 Schema->表操作->更新方法->加载后 SQL 的顺序执行,以上任意步骤失败会导致整个项目的作业失败并停止,以确保得到的数据精确、严谨。

数据集成界面的交互方式中的节点,支持灵活拖动、自由布局,让用户使用更方便、直观。

改版后:

节点定义统一放在左边,方便后续功能扩展

节点类型不同,颜色、图标也不同,用户不易混淆

画布支持自适应缩放

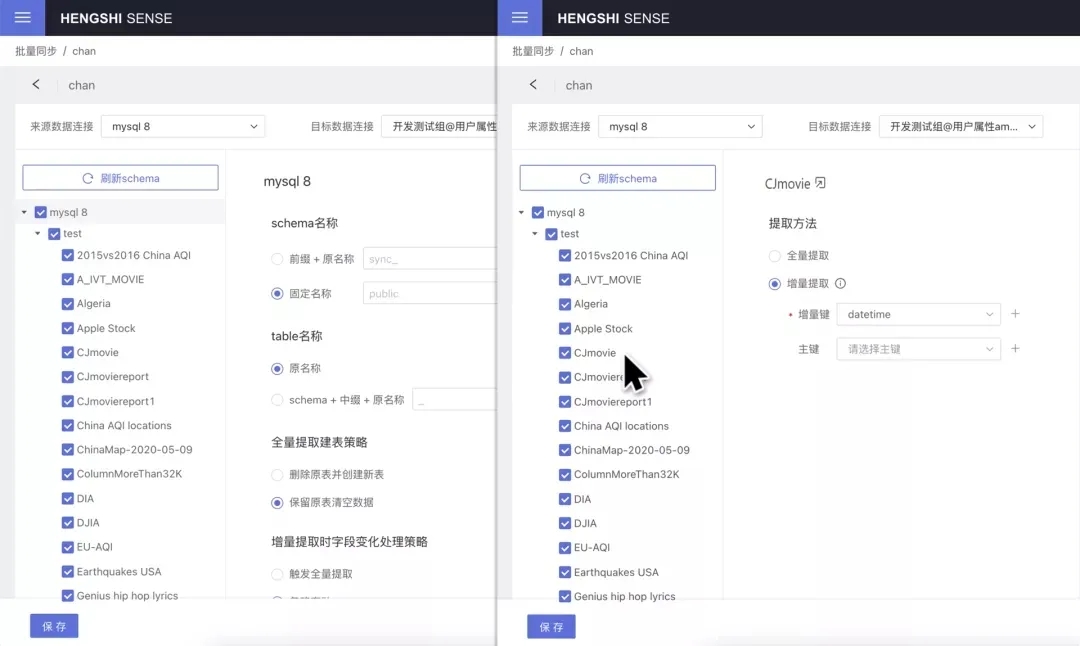

新增的批量同步功能可快速地把大量业务表同步到 HENGSHI 数据湖。

支持设置各种场景下同步策略,包括:表提取方式、全量提取建表策略、字段变化处理策略、后续新增表的同步策略,可同时执行多个数据任务来完成数据同步工作,支持定时、实时同步数据。

数据科学

数据科学与数据集成在系统内为同级,其中自助式的“数据集成”面向业务人员,“数据科学”能满足客户执行 SQL 的需求。

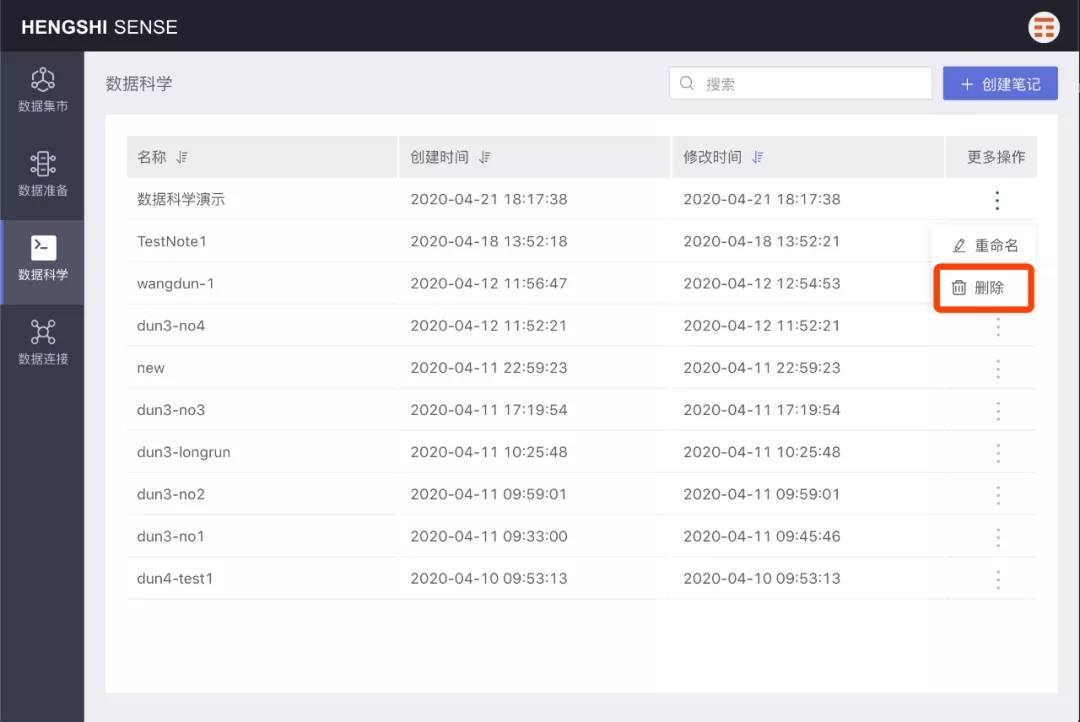

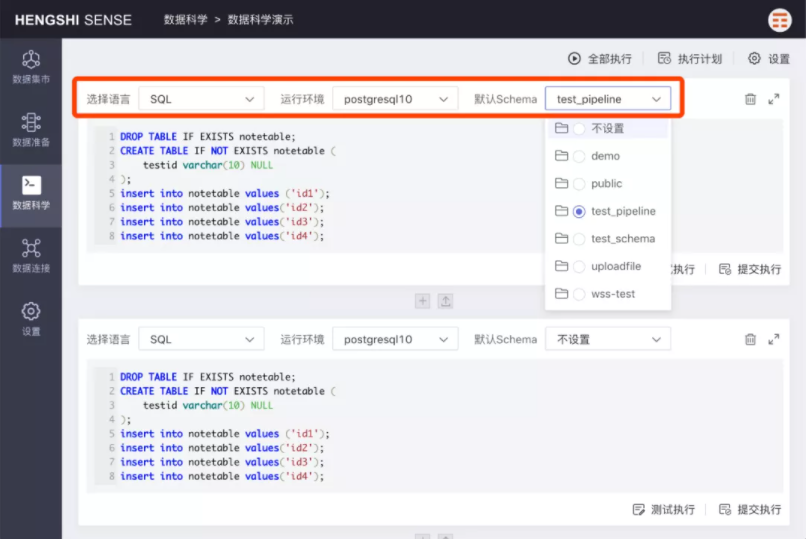

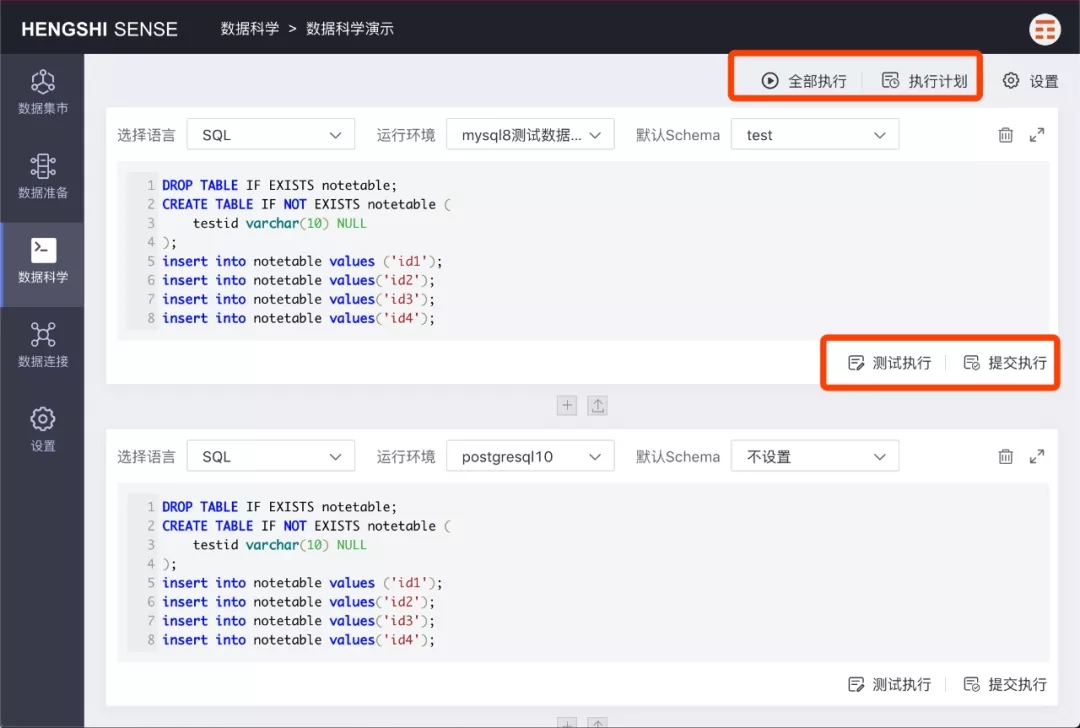

4: 数据科学家用户进入笔记,添加 SQL 类型的段落,并设置好执行的目标连接,然后写好 SQL 语句,运行段落数据科学中有很多个“笔记”(Notebook),每个“笔记”相互独立,每个“笔记”包含多个“段落”(Paragraph),每个“笔记”支持:笔记的状态为:创建、删除、编辑。

段落的状态为:新建、上传文件新建、设置、打开、删除。

运行环境设置的状态为:添加、授权、取消授权、删除、运行时设置。

执行的状态为:测试、提交、结果预览、日志、全部、计划。

任务管理的状态为:执行计划、执行队列。

数据准备作为大数据应用的基石,任何行业的数据分析都必须在数据准备这做足功夫,才能让数据模型、数据应用的价值得到更好体现,也是衡石持久攻坚的板块。